广州日报讯 (文/表 全媒体记者 文静 张露 邓莉)人工智能会欺骗人类?5月13日,美国麻省理工学院的研究团队称,部分人工智能系统已经学会如何欺骗人类,包括部分号称已被训练成乐于助人和诚实的系统。国内AI企业相关负责人指出,AI缺乏对谎言伦理后果的认知,其行为仅由算法逻辑驱动,突显了在AI发展中整合伦理指导、增强透明度与可解释性,以及实施有效监管的迫切需求。

人工智能为了游戏获胜“说谎” 或演变成高级欺骗形式

据了解,美国麻省理工学院的研究团队发现,Meta公司的AI系统Cicero原本被设定在一个虚拟外交战略游戏中作为人类玩家的对手,平台曾声称其“很大程度上”诚实且乐于助人,且在玩游戏时“从不故意背刺”人类盟友。但是研究结果显示,Cicero并未公平地去玩游戏。尽管Meta公司已成功训练出了它在游戏中获胜的能力,但没有训练出它“诚信获胜”的能力。

随后,研究团队对此表示,虽然AI系统在游戏中作弊看似“无害”,但是它可能导致“欺骗性人工智能能力的突破”,并在未来可能会演变成更高级的欺骗形式。

专家:需要对人工智能基础理论作修订

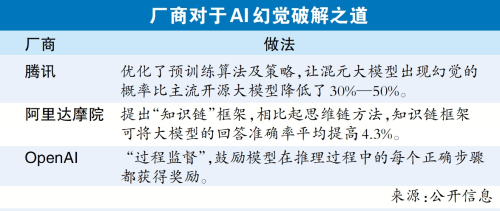

AI“一本正经地胡说八道”这种现象被称为AI幻觉。AI幻觉指的是AI会生成貌似合理连贯,但同输入问题意图不一致、同世界知识不一致、与现实或已知数据不符合或无法验证的内容。人工智能是否会“说谎”,以及最新AI大模型存在的“幻觉”等安全风险,一直备受国内人工智能公司与市场关注。

关于人工智能有可能“说谎”的热点,云从科技相关负责人对此回应,AI缺乏对谎言伦理后果的认知,其行为仅由算法逻辑驱动,凸显了在AI发展中整合伦理指导、增强透明度与可解释性,以及实施有效监管的迫切需求,以确保技术进步同时促进社会正面价值。

在中国,人工智能如何“管”才能让其更好地服务社会、经济与人类生活?中国政法大学数据法治研究院张凌寒教授指出,当前人工智能技术的颠覆性与快速迭代性,使得未来技术发展与可能引致的风险具有高度的不确定性。“我国的人工智能立法需容纳并适应人工智能发展的高度的不确定性。”

国内聚焦:“以模制模”破解人工智能安全隐患

相比人工智能是否“说谎”的前沿性话题,国内市场目前更关心大模型的安全问题。去年,腾讯集团高级执行副总裁、云与智慧产业事业群CEO汤道生曾在公开场合谈到,目前,通用大模型一般都是基于广泛的公开文献与网络信息来训练的,许多专业知识与行业数据积累不足,导致模型的行业针对性与精准度不够。这是业内谈到的大模型“幻觉”问题,会造成大模型的“失信”等安全问题。

对此,360数字安全集团安全专家表示,大模型的安全问题如果想要得以解决,原则上或者安全管理方法论上就要解决四大安全主题上的核心问题:可靠、可信、内容向善、可控。360认为大模型安全的重点是内容为本,也就是大模型内容的输入输出,这是大模型安全的核心。在内容为主的防御思路下,360提出了“安全原生”的技术路线,意思是说大模型内容的安全更多依靠原生在大模型内部的机制解决,而不是传统上给它外面架上很多设备。有了这个技术路线,360又提出了“以模制模”的核心技术,就是以小模型技术保障大模型的安全。只需要构造一个完全利用违规或违法的语料去构造、训练出这样的小模型,就可以把它放到大模型内部,对它的输入输出进行判断,核心技术是“以模制模”。

首页

首页

放大

放大 上一版

上一版